En la Parte I de esta serie, describimos la tecnología que hay detrás de ChatGPT, cómo funciona, sus aplicaciones y las limitaciones que las organizaciones deben conocer antes de subirse al tren de la exageración. Al tratar de discernir las oportunidades que esta tecnología presenta para su organización, es probable que se enfrente a una niebla de incertidumbre en términos de:

- ¿Qué problemas empresariales deberíamos resolver con ChatGPT y, en general, con la IA? (adecuación producto-mercado)

- ¿Qué problemas empresariales podemos resolver con ChatGPT y la IA? (ajuste problema-solución)

- ¿Cuál es el esfuerzo y el coste que supone aprovechar o crear estas capacidades de IA?

- ¿Cuáles son los riesgos asociados y cómo podemos reducirlos?

- ¿Cómo podemos ofrecer valor de forma rápida y fiable?

En este artículo, abordamos estas cuestiones adoptando una visión amplia de la IA y compartiendo cinco recomendaciones que hemos destilado de nuestra experiencia en el suministro de soluciones de IA.

1. Adecuación del producto al mercado: Empezar por el problema del cliente, no por la herramienta

Con la emoción que rodea a ChatGPT, es tentador caer en la trampa de un enfoque que da prioridad a la tecnología: tenemos un martillo brillante, ¿qué podemos golpear con él? Un error empresarial común en los proyectos de IA es empezar con los datos disponibles o las técnicas de IA del momento. En lugar de eso, hay que partir de un problema concreto del cliente.

Sin un problema claro y convincente que esté respaldado por la voz del cliente, nos encontraremos en un vacío que se llena rápidamente con suposiciones "expertas" pero sin fundamento. La presión de inferir amenazas a partir de las afirmaciones de la competencia en los medios de comunicación y las culturas de liderazgo que valoran más el "saber" que la experimentación pueden llevar a malgastar meses de inversión en ingeniería. Como dijo Peter Drucker, "no hay nada tan inútil como hacer eficazmente algo que no debería haberse hecho".

Hay varias prácticas que podemos aplicar para mejorar nuestras probabilidades de apostar por lo correcto. Una de estas prácticas es el Discovery, que nos ayuda a desarrollar la claridad en la lucha del cliente, nuestra visión, el espacio del problema, las propuestas de valor y los casos de uso de alto valor. Esta inversión de unas semanas con las personas adecuadas en la mesa -clientes, producto, partes interesadas del negocio, (en lugar de sólo científicos de datos e ingenieros)- puede ayudarnos a centrarnos en ideas que aportarán valor a los clientes y al negocio y evitar perder el tiempo de la gente en esfuerzos sin resultados.

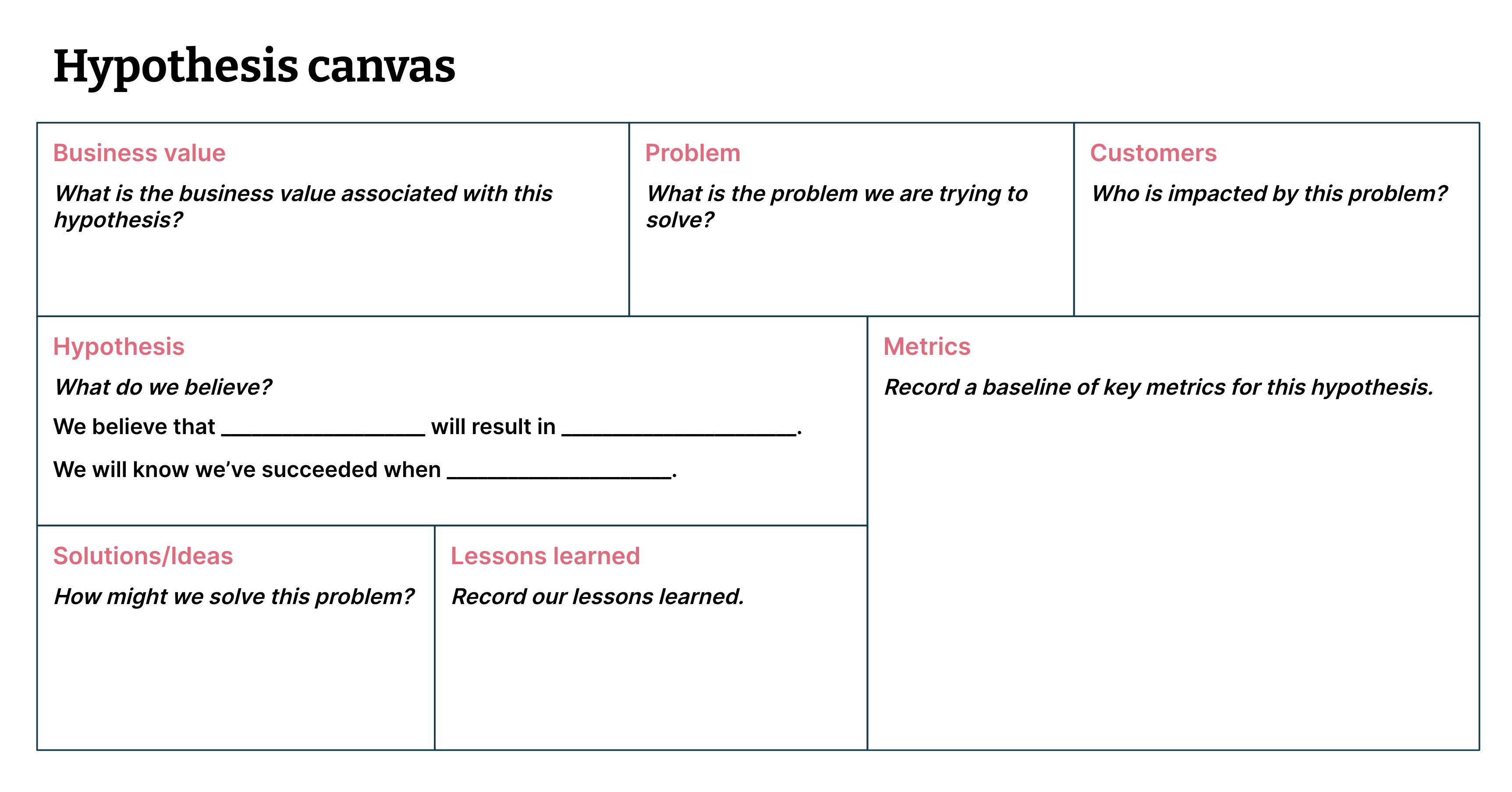

Herramientas como el ML Canvas y el canvas de hipótesis son útiles para evaluar la propuesta de valor y la viabilidad de utilizar la IA para resolver nuestros problemas más acuciantes (véase la figura 1).

Figura 1: El lienzo de hipótesis nos ayuda a articular y enmarcar supuestos comprobables (es decir, hipótesis) (Imagen de Data-driven Hypothesis Development).

2. Adecuación problema-solución: Elegir las herramientas de IA adecuadas para crear valor

Esta recomendación trata de ampliar su conjunto de herramientas para encontrar los enfoques más adecuados y rentables para su caso de uso de alto valor, y evitar malgastar esfuerzos en técnicas de IA innecesariamente complejas. Reconoce que, aunque ChatGPT podría desencadenar conversaciones, los LLM podrían no ser la solución adecuada a tu problema.

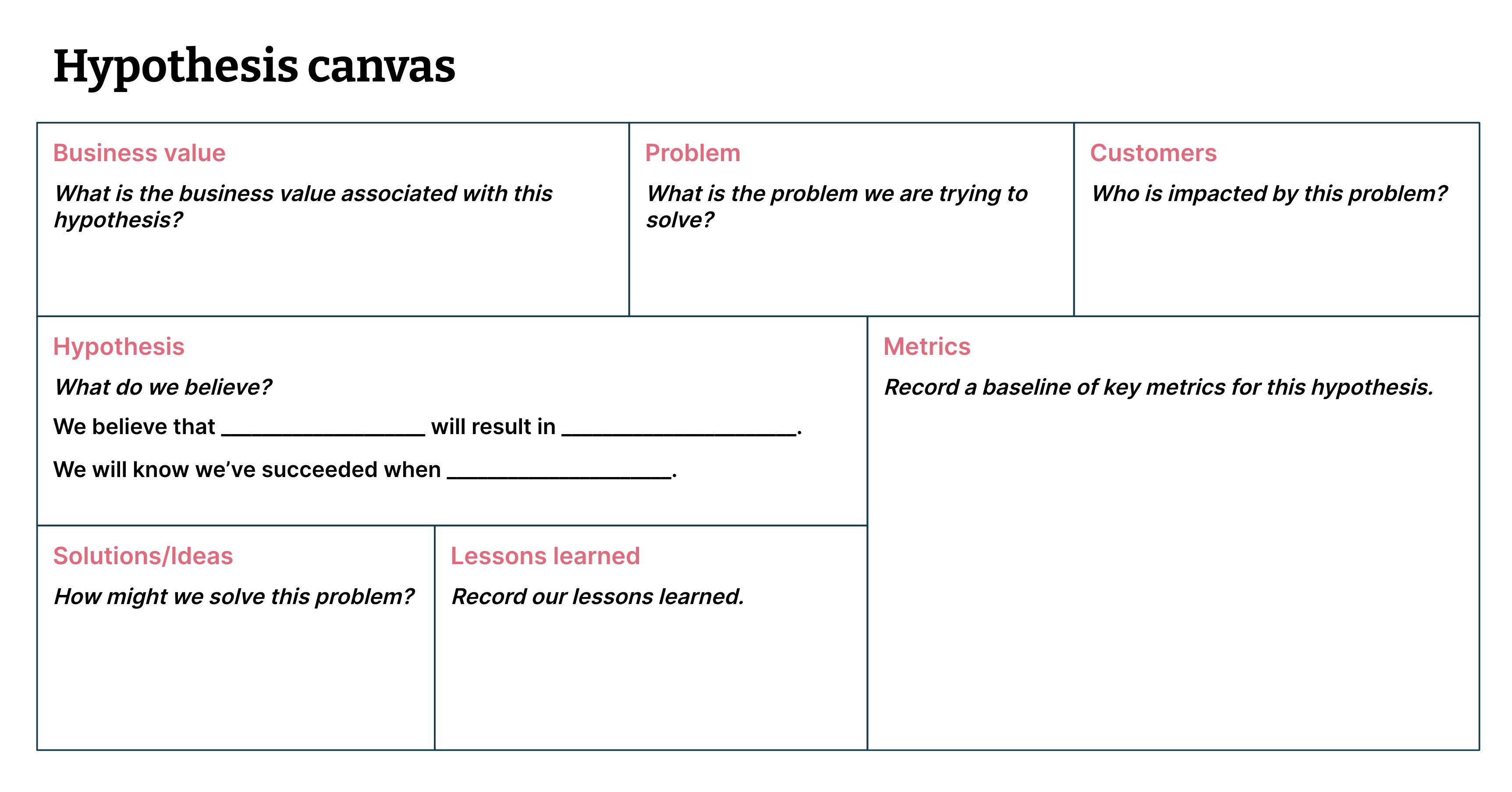

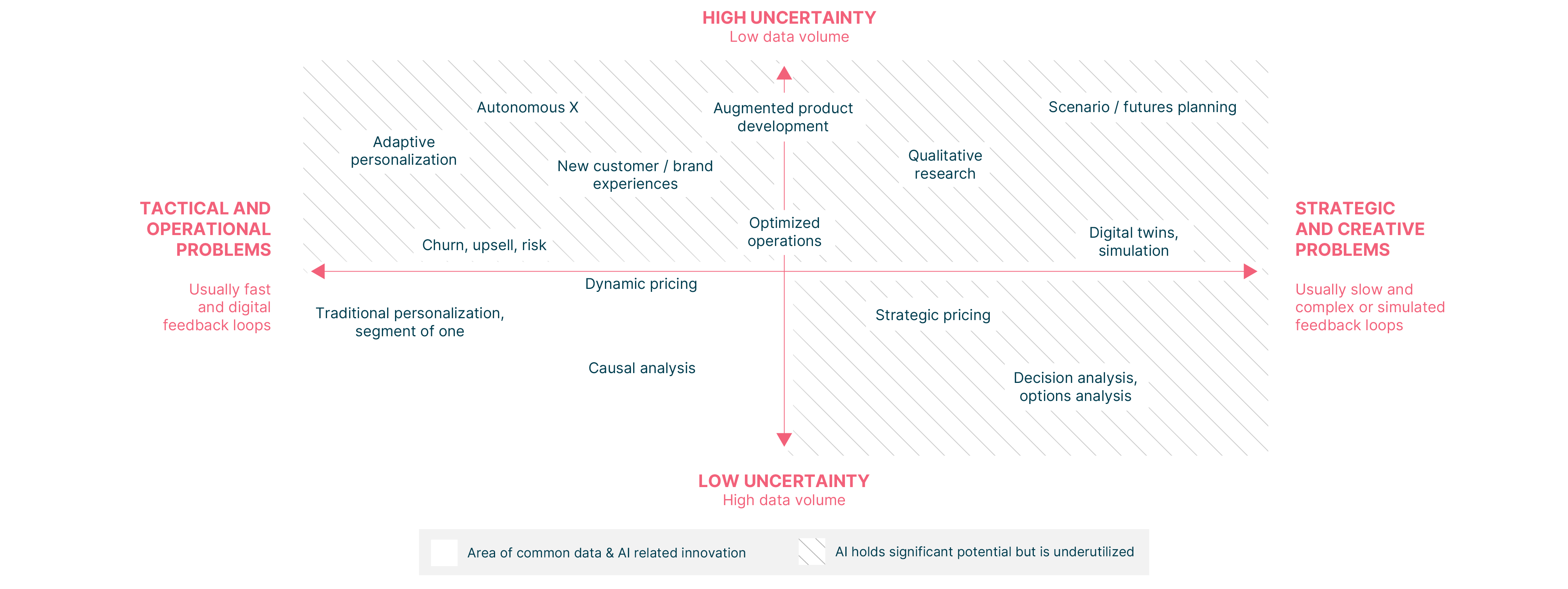

Más allá de los LLM, existen otras técnicas de IA que, según nuestra experiencia, pueden aumentar eficazmente la capacidad de las empresas para tomar decisiones operativas y estratégicas óptimas en el día a día, y con muchos menos datos y recursos informáticos (véase la Figura 2).

Por ejemplo, en el cuadrante superior izquierdo, Thoughtworks trabajó con una empresa finlandesa de diseño de estilo de vida- y aplicó el aprendizaje por refuerzo para crear una experiencia de compra adaptable y personalizada para los clientes. Construimos una fábrica de decisiones que aprende del comportamiento de los usuarios en tiempo real, y no requiere activos de datos anteriores ni conocimientos expertos de ciencia de datos para ser escalada a través de las plataformas digitales de la empresa. A las pocas horas de su lanzamiento, la fábrica de decisiones generó un aumento del 41% en el número de clics en la página principal y, al cabo de cinco semanas, un incremento del 24% en los ingresos medios por usuario.

En el centro de los dos cuadrantes superiores, aplicamos técnicas de investigación de operaciones para crear un modelo que ayudó al aeropuerto de Kittilä a aliviar la fuerte presión sobre la infraestructura y los recursos aeroportuarios durante la temporada alta de viajes. Esto redujo el tiempo de planificación de 3 horas a 30 segundos (una reducción del 99,7%), y disminuyó la proporción de retrasos de vuelos relacionados con el aeropuerto en un 61% (a pesar de que el número de vuelos aumentó un 12% respecto al año anterior). La disminución de los retrasos supuso un ahorro mensual estimado de 500.000 euros y la puntuación Net Promoter Score (NPS) del aeropuerto aumentó 20 puntos.

Estos son sólo algunos ejemplos del potencial sin explotar de la familia de técnicas maduras de IA aumentada. Elegir la técnica de IA adecuada para su problema le permite ser más inteligente con los datos que conserva y, al hacerlo, reduce significativamente el coste, la complejidad y el riesgo que implica la conservación de montones de datos históricos.

3. Esfuerzo: Los modelos más grandes conllevan mayores superficies de error

Arte por Dougal McPherson

Un contemporáneo menos conocido de ChatGPT es la IA Galáctica de Meta, que se entrenó con 48 millones de artículos de investigación y pretendía servir de apoyo a la escritura científica. Sin embargo, la demo se cerró a los dos días porque producía información errónea y pseudociencia, a la vez que sonaba autorizada y convincente.

De esta historia con moraleja se pueden extraer dos conclusiones. En primer lugar, arrojar montañas de datos a un modelo no significa que vayamos a obtener resultados acordes con nuestras intenciones y expectativas. En segundo lugar, la creación y producción de modelos ML sin pruebas exhaustivas tiene un coste significativo para los seres humanos y la sociedad. También aumenta el riesgo de daños financieros y de reputación para una empresa. En una noticia más reciente, un portavoz de Google se hizo eco de esto cuando dijo que el "error de 100.000 millones de dólares" de Google Bard subrayaba "la importancia de un proceso de pruebas riguroso".

Podemos y debemos probar los modelos de IA. Podemos hacerlo utilizando una serie de técnicas de prueba de ML para descubrir fuentes de error y daños antes de lanzar ningún modelo. Al definir las fitness functions de los modelos -medidas objetivas de "suficientemente bueno" o "mejor que antes"- podemos probar nuestros modelos y detectar problemas antes de que causen problemas en la producción. Si nos esforzamos por articular estas funciones de aptitud del modelo, lo más probable es que acabemos descubriendo que no es apto para la producción. Para las aplicaciones de IA generativa, esto supondrá un esfuerzo no trivial que debería tenerse en cuenta a la hora de decidir qué oportunidades se van a aprovechar.

También debemos probar el sistema desde el punto de vista de la seguridad y realizar ejercicios de modelado de amenazas para identificar posibles modos de fallo (por ejemplo, ataques de adversarios e inyecciones puntuales). La ausencia de pruebas es una receta para el trabajo interminable y los incidentes de producción para los profesionales del aprendizaje automático. Una estrategia de pruebas exhaustiva es esencial si quiere asegurarse de que sus inversiones conducen a un producto de alta calidad y encantador.

4. Riesgo: la gobernanza y la ética deben ser un marco de referencia, no una ocurrencia tardía.

“La ética de la IA no está separada de otras éticas, aislada en un espacio propio mucho más sexy. La ética es ética, e incluso la ética de la IA trata en última instancia de cómo tratamos a los demás y cómo protegemos los derechos humanos, en particular de los más vulnerables." – Rachel Thomas

El Informe del MIT sobre el Estado de la Tecnología Responsable, patrocinado por Thoughtworks, observó que la tecnología responsable no es una perogrullada para sentirse bien, sino una característica organizativa tangible que contribuye a mejorar la captación y retención de clientes, a mejorar la percepción de la marca y a prevenir las consecuencias negativas y el riesgo de marca asociado.

La IA responsable es un campo incipiente pero en crecimiento, y existen técnicas de evaluación -como el lienzo ético de datos, el análisis de modos de fallo y efectos, entre otras- que puede emplear para evaluar los riesgos éticos de su producto. Siempre es beneficioso "desplazar la ética hacia la izquierda" (trasladar las consideraciones éticas a una fase más temprana del proceso) implicando a las partes interesadas pertinentes -que abarcan el producto, la ingeniería, los aspectos jurídicos, la entrega, la seguridad, la gobernanza, los usuarios de prueba, etc.- para identificar:

- Modos de fallo y fuentes de daño de un producto

- Actores que pueden comprometer o abusar del producto, y cómo

- Segmentos que son vulnerables a impactos adversos

- Estrategias de mitigación correspondientes para cada riesgo

Los riesgos (donde riesgo = probabilidad x impacto) que identifiquemos deben gestionarse activamente junto con otros riesgos de entrega de forma continua. Estas evaluaciones no son ejercicios puntuales, sino que deben formar parte del marco de gobernanza de los datos y gobernanza de ML, teniendo en cuenta cómo la gobernanza puede ser ligera y procesable.

5. Ejecución: Acelerar la experimentación y la entrega con prácticas de ingeniería de producto Lean.

Muchas organizaciones y equipos comienzan su viaje de IA/ML con grandes esperanzas, pero casi inevitablemente luchan por aprovechar el potencial de la IA debido a sumideros de tiempo imprevistos y desvíos imprevistos: el diablo está en el detalle de los datos. En 2019, se informó que el 87% de los proyectos de ciencia de datos nunca llegan a la producción. En 2021, incluso entre las empresas que han desplegado con éxito modelos ML en producción, el 64 % de ellas tarda más de un mes en desplegar un nuevo modelo, un aumento con respecto al 56 % de 2020.

Estos impedimentos a la hora de aportar valor frustran a todos los implicados: ejecutivos, patrocinadores de inversiones, profesionales del ML y equipos de producto, entre otros. La buena noticia es que no tiene por qué ser así.

En nuestra experiencia, las prácticas de entrega Lean nos han ayudado sistemáticamente a iterar hacia la construcción de lo correcto:

- Centrarnos en la voz del cliente

- Mejorar continuamente nuestros procesos para aumentar el flujo de valor

- Reducir los residuos al crear soluciones de IA.

La entrega continua para el aprendizaje automático (CD4ML) también puede ayudarnos a mejorar los resultados empresariales acelerando la experimentación y mejorando la fiabilidad. Los ejecutivos y los líderes de ingeniería pueden ayudar a dirigir la organización hacia estos resultados deseables abogando por prácticas eficaces de ingeniería y entrega.

Reflexiones finales

Nuestra experiencia nos lleva a una visión más equilibrada: los seres humanos siguen siendo agentes del cambio en nuestro mundo y la IA es más adecuada para aumentar, no sustituir, a los seres humanos. Pero sin cuidado, intención e integridad, los sistemas que crean algunos grupos pueden hacer más mal que bien. Como tecnólogos, tenemos la capacidad y el deber de diseñar sistemas de IA responsables, centrados en el ser humano, para mejorar los resultados de unos y otros.

Aviso legal: Las declaraciones y opiniones expresadas en este artículo son las del autor/a o autores y no reflejan necesariamente las posiciones de Thoughtworks.