La importancia de las pruebas de inteligencia artificial

A medida que las empresas se esfuerzan por obtener una ventaja sobre su competencia, muchas están adoptando la idea de infundir aplicaciones centrales con capacidades de inteligencia artificial (IA). Es una idea atractiva, pero aquí está el detalle: pocas organizaciones están equipadas para manejar la complejidad que esto conlleva.

Este punto ha sido destacado agudamente por Forrester Research en su último informe "Es hora de tomarse en serio la prueba de su inteligencia artificial". Mientras que la IA es cada vez más ubicua en el software empresarial, Forrester advierte que "se presta poca atención a la prueba de las aplicaciones resultantes impregnadas de IA".

¿Por qué eso importa? Después de todo, ¿no son estos sistemas inteligentes lo suficientemente astutos como para corregirse a sí mismos? Francamente, la respuesta es "no". Y aunque Forrester destaca correctamente la necesidad de que las empresas introduzcan programas de prueba más integrales para sus iniciativas de IA, en Thoughtworks, uno de los proveedores entrevistados para este informe, iríamos aún más lejos.

Las pruebas efectivas pueden ayudar a desbloquear más valor de la IA

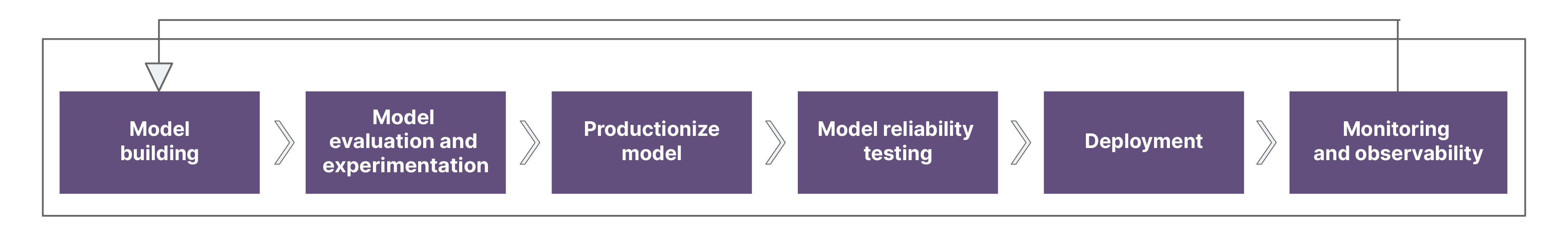

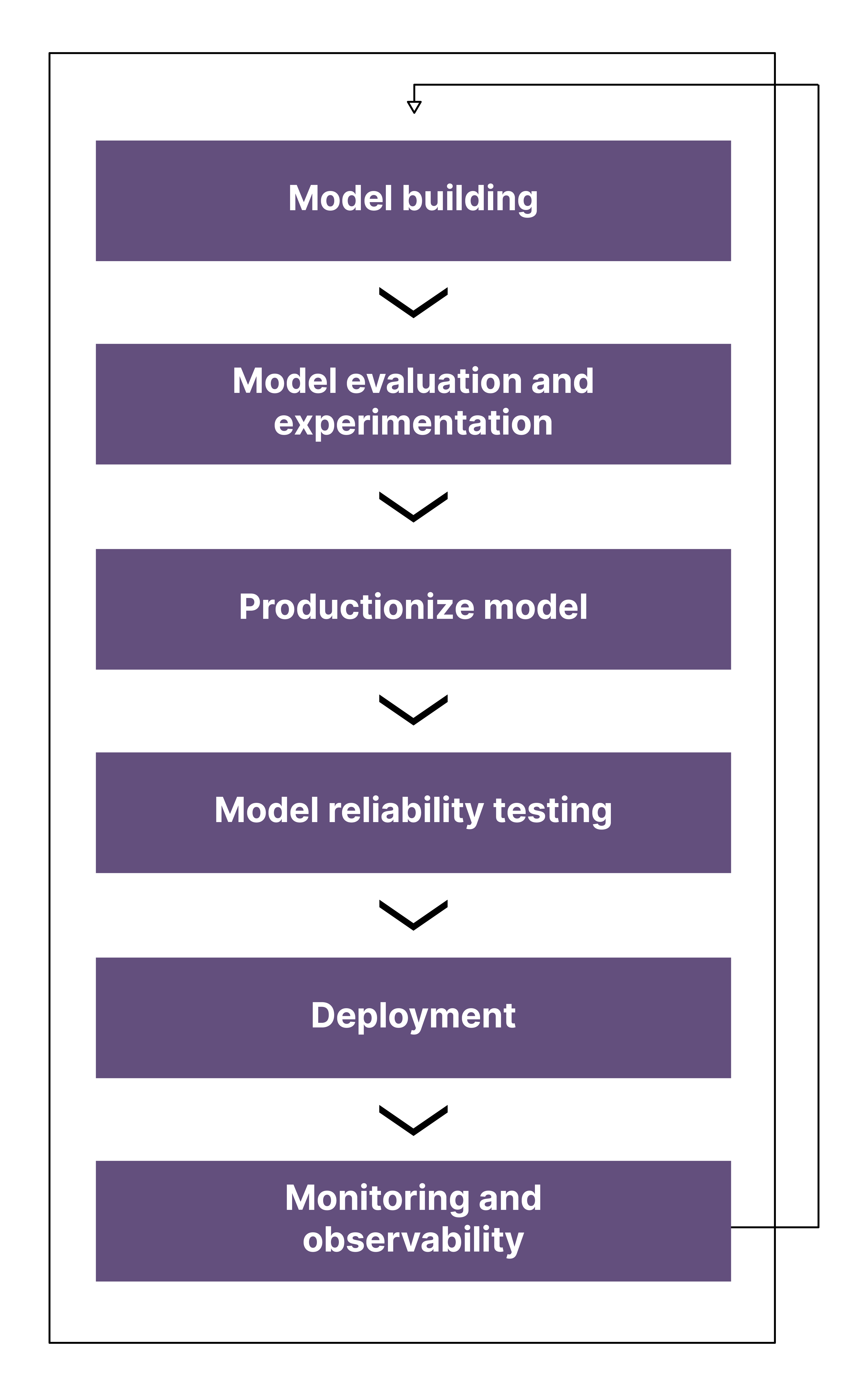

Hemos trabajado con muchos clientes en los últimos años para maximizar su rendimiento con soluciones de IA y hemos aprendido por qué las pruebas son una parte esencial para poder implementar con confianza estos sistemas en producción y, cuando sea necesario, evolucionarlos.

En el informe de dos partes, los analistas de Forrester exploran cómo probar las aplicaciones impregnadas de IA (AIIAs) y la pila tecnológica necesaria para las pruebas automatizadas y continuas de AIIAs. En la Parte Dos, señalan:

No hay una bala mágica para una solución integrada y automatizada de desarrollo, entrega y prueba para AIIAs, aún. Sin embargo, algunas soluciones tempranas valen la pena probar: Thoughtworks, una de las empresas fundadoras de entrega continua, ha reunido un proceso de entrega continua y una cadena de herramientas llamada CD4ML, que respalda el proceso necesario para construir, probar e implementar AIIAs. CD4ML le permite construir canalizaciones de datos para obtener los datos de entrenamiento y prueba necesarios para los modelos, canalizaciones de modelos y canalizaciones de código que incluyen pruebas y soporte para la automatización de pruebas.

La buena noticia es que, al igual que la entrega continua, muchos de los elementos de la estrategia de prueba que necesita para los modelos de IA se pueden replicar a partir de buenas prácticas en otros lugares, por ejemplo, al impulsar estándares de calidad de datos en todos los sistemas o al utilizar una pirámide de prueba como base para las pruebas en el ciclo de vida del desarrollo de software.

Identificar las señales de que sus pruebas de IA son inadecuadas

A medida que la IA se vuelve cada vez más ubicua en la pila tecnológica empresarial, también lo hacen los riesgos de pruebas inadecuadas. La IA generativa ha democratizado la tecnología aún más y, al hacerlo, ha ampliado el radio de acción para posibles problemas.

Y la cantidad de fallas de alto perfil está creciendo. Pero no es necesario que espere hasta convertirse en noticia de primera plana: hay señales de advertencia de que su régimen actual de pruebas de IA necesita una reconsideración.

Tal vez haya detectado una disminución notable en el rendimiento; tal vez no esté viendo el valor que solía obtener de sus sistemas. Tal vez se ha precipitado sin evaluar si sus datos de entrenamiento coinciden con los escenarios que encontrará en el mundo real. Otros signos clave incluyen: incidentes de producción; lucha constante; pruebas manuales excesivas antes de que algo pueda lanzarse a producción, reduciendo la velocidad al mercado; y la incapacidad para refactorizar de manera segura y frecuente, agravando así estos problemas.

Cualquiera que sea la situación en la que se encuentre, la Parte Dos del informe de Forrester ha proporcionado principios rectores para probar la IA. Estos incluyen:

- Pruebas unitarias durante el desarrollo.

- Pruebas en producción.

- Pruebas de rendimiento de modelos y experiencia de extremo a extremo.

- Pruebas de unidad y funcionalidad para prevenir sesgos.

- Pruebas de integración.

Creemos que ese es un consejo útil, destacando la necesidad de una diversidad de tipos de prueba, que Forrester señala en la Parte Dos de su informe también significa coordinar diferentes funciones y roles. Pero antes de simplemente preguntar "¿Cómo probaremos esto?", es posible que desee considerar las preguntas: ¿Deberíamos hacer esto? ¿Y cómo deberíamos hacer esto? Las pruebas no son algo que se haga a una solución, sino que la capacidad de prueba también es un requisito clave al decidir qué problemas abordar y cómo diseñar soluciones para ellos. Las pruebas también tienen connotaciones culturales: en muchos casos, las organizaciones hablan de pruebas de labios para afuera; eso dificulta implementar los cambios necesarios para priorizar las pruebas y generar un impacto comercial real.

Eliminar las incertidumbres de las pruebas de IA

Como señala Forrester en la Parte Dos del informe, el uso de algoritmos de aprendizaje profundo, algoritmos de aprendizaje por refuerzo y modelos de lenguaje grandes resulta en sistemas opacos y fuertemente acoplados que son difíciles de probar.

Estos tipos de sistemas de IA están diseñados para volverse más inteligentes con el tiempo, por ejemplo, un ejemplo muy simple podría ser mejorar en la identificación de imágenes que contienen perros a partir de un conjunto grande y aleatorio de imágenes. Para cuando el modelo de IA pueda alcanzar niveles de rendimiento equivalentes a los humanos, puede no estar claro cómo el modelo logró esos resultados, o tal vez no siempre obtenga los mismos resultados; se dice que tales sistemas de IA carecen de 'explicabilidad' y 'comportamiento determinista'.

Pero aún podemos aplicar prácticas de prueba probadas, incluso teniendo en cuenta problemas de explicabilidad o comportamiento determinista. Un sistema diseñado para ser probado le permite identificar todas las fuentes de variación de entrada, como semillas aleatorias, construcción de comandos, temperatura LLM y parámetros de muestreo, y cuanto más de estos pueda mantener constante en un entorno de prueba, más debería esperar un comportamiento determinista. En aplicaciones para las cuales la explicabilidad es un requisito, elija modelos que sean interpretables por diseño (como los árboles de decisiones). Para modelos más opacos, las pruebas aún son posibles y, de hecho, requieren un enfoque especialmente sistemático para abordar fallas en casos extremos.

Podría comenzar creando una "tarjeta de modelo" para incluir los detalles fundamentales de cómo funciona un modelo de IA, en qué se ha probado, si aprende en línea. Este tipo de documentación fundamental eleva los niveles de conciencia y evalúa críticamente lo que estos sistemas están haciendo: lo que han aprendido y cómo, y qué decisiones humanas previas guían su comportamiento. También debería ser un artefacto "vivo", no uno que solo se crea en la etapa de diseño, sino uno que evoluciona con el tiempo.

Ahora puedes probar que tu algoritmo de IA está correctamente implementado en casos conocidos y también realizar simulaciones, muestreando el espacio de entradas esperado en producción. No tendrás la garantía de que funcione en todos los casos, pero sabrás si está totalmente equivocado y tendrás una idea de los tipos de fallos que puedes esperar. También puedes comprobar la reproducibilidad de los resultados y la sensibilidad de los parámetros.

Invierta sus esfuerzos de prueba de IA sabiamente

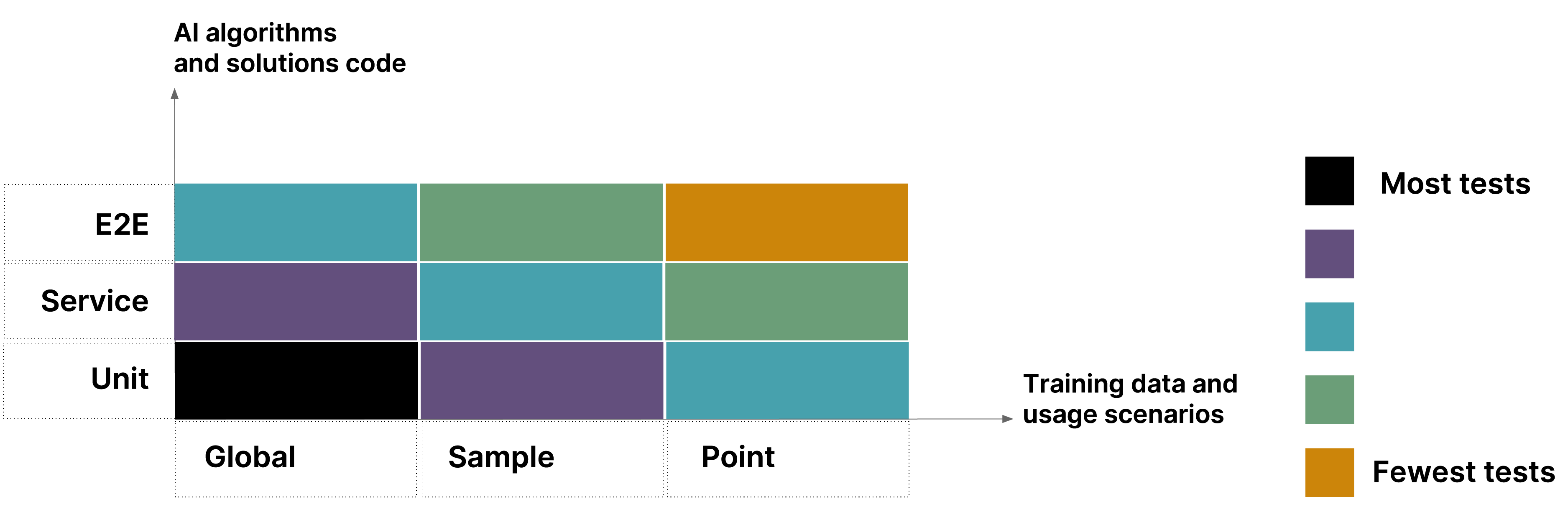

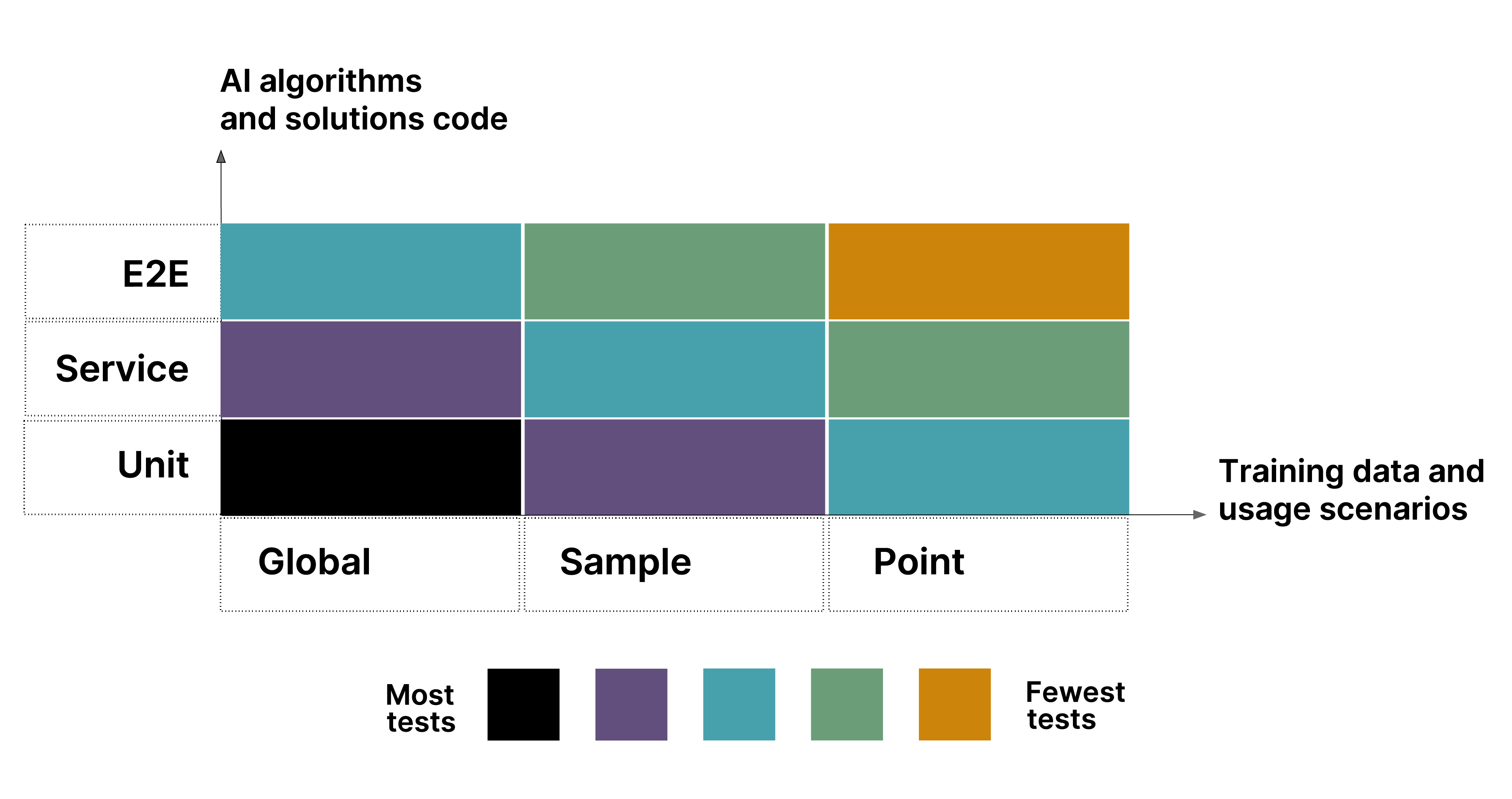

Para establecer el nivel y la amplitud de las pruebas que son apropiadas para sus casos de uso, creemos que es útil enmarcar esta decisión en términos de la Pirámide de Pruebas: una metáfora que nos dice agrupar las pruebas en compartimientos de granularidad diferente. También obtendrá una idea de cuántas pruebas debería tener en cada uno de estos grupos, para que pueda establecer qué pruebas son apropiadas para, por ejemplo, protegerse contra datos sesgados.

Esa idea de lo que constituye datos "buenos" es la pieza final del rompecabezas de las pruebas. En Thoughtworks, construimos bases de datos sólidas para aplicaciones habilitadas para la IA. Tener una buena comprensión de los datos que ingresan le permite probar más eficaz y eficientemente la IA y aislar problemas.

Para muchos de los clientes a los que hemos ayudado, el primer paso para aprovechar con éxito la IA es establecer estándares de calidad de datos, adoptando una mentalidad de producto de datos, reduciendo así el tiempo de comercialización de las iniciativas de IA al garantizar que la calidad esté incorporada en los datos en la fuente y reduciendo el riesgo a través de una gobernanza de datos adecuada.

Ni la Pirámide de Pruebas ni la aplicación del pensamiento de productos son nuevos para la mayoría de las empresas. Creemos que eso es una fortaleza. Sí, la complejidad y el rendimiento de los sistemas de IA de hoy pueden ser desalentadores, pero dada su importancia, creemos que la aplicación inteligente de ideas probadas y probadas es la mejor base para un régimen de pruebas práctico. Y eso, en última instancia, dará a los líderes empresariales una mayor confianza en que pueden aprovechar la tecnología de IA de manera efectiva.